Speicherfrequenz ist wichtiger als GPU-Frequenz

Nach einigem Herumtüfteln im Wattman können wir nun mit großer Sicherheit behaupten, was wir seit Jahren ahnen: Die Geschwindigkeit des angebundenen GPU-Speichers ist das Haupt-Nadelöhr der GPU-Beschleunigung unter Resolve. Wer den Speicher der Grafikkarte beschleunigt/übertaktet gewinnt am deutlichsten zusätzliche Leistung. Dies gilt im übrigen auch für fast alle anderen rechenintensiven GPU-Anwendungen (wie beispielsweise auch viele Crypo-Mining-Algorithmen oder andere Schnitt- und Compositing-Programme). Ein Hochschrauben der Prozessorfrequenz bringt dagegen nur äußerst marginale Performance-Gewinne.

Interessanterweise sind die meisten AMD-Karten sehr tolerant gegenüber Undervolting. Schafft man es für seine Grafikkarte eine stabile, niedrigere Betriebsspannung einzustellen, so sinkt der Stromverbrauch und damit auch Wärme und Hitze der Karte erheblich. AMD setzt dabei die Chip-Spannung aller Karten auf ein relativ hohes Niveau (um die 1200 mV bei maximalem Boost). Die meisten der verkauften Karten laufen jedoch auch mit deutlich geringerer Spannung hundertprozentig stabil. Setzt man die Spannung für die Rechenwerke herunter, so braucht die Karte weniger Strom wird weniger heiß und kann dabei in der Regel sogar höher getaktet werden. Da im Videoschnittbereich ein höherer Takt der GPU-Shader jedoch kaum etwas bringt, nutzen wir die gewonnen Reserven lieber für eine höhere Frequenz beim HBM-Speicher. Unser Optimierungsziel ist ein möglichst hoher Speichertakt, bei moderater Rechnenfrequenz der Shader.

Den Speicher kann man (in bestimmten Grenzen) dagegen umso besser übertakten, je mehr Spannung anliegt. Allerdings gibt AMD eben die Speicherspannung offenbar nicht zur Manipulation per Wattman frei. Um den Speicher einer Vega 56 höher (wie eine Vega 64) zu übertakten muss man eben dafür das Bios flashen. Die Vega 56 erlaubt maximal 1250 mV Speicher-Spannung, die Vega 64 erlaubt bis zu 1350 mV.

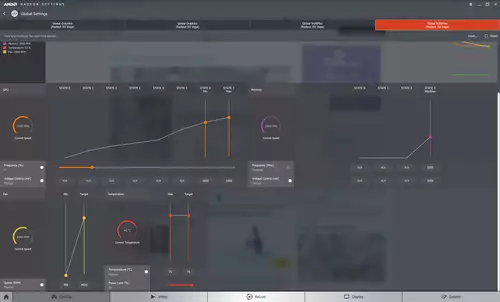

Hier mal ein Blick auf unsere Wattman Settings, mit denen wir zwei Vega 56 Karten absolut stabil mit Resolve auch unter voller Last betreiben können:

Was bringts? Vega56 unter Resolve 14

Nachdem Resolve nun auch in der finalen Version 14 vorliegt konnten wir feststellen, dass sich die Messergebnisse nur noch leicht gegenüber den letzten Betas verändert haben. Wir hatten für den folgenden Test zwei AMD Vega 56 und eine GTX 1080 Ti zur Verfügung, die bislang die stärkste GPU unter 1.000 Euro für Resolve darstellte. Vor einer Analyse hier mal die nackten Zahlen:

| GPU | TFlops ca. | Min. Preis ca. (September 2017) | Max Num Curved Nodes Full 24p Playback | Motion Blur Better,Large,30.0 | Spatial NR,small,50,50 | Spatial NR,small,100,100 | Temp NR 1 Faster Small 50 50 50 | Temp NR 2 better large 50 50 50 |

|---|---|---|---|---|---|---|---|---|

Vega 56 (Stock) | 10,5 | 400-500 Euro | 44 | 16,5 | 24 | 13,5 | 24 | 14,5 |

Vega 56 BIOS V64 | 10,5 | 400-500 Euro | 51 | 18,5 | 24 | 14,5 | 24 | 15 |

GTX1080Ti (Stock) | 11,5 | 710 Euro | 57 | 19,5 | 24 | 11,5 | 24 | 16,5 |

Vega 56 BIOS V64 HBM 1050MHz | 10,5 | 400-500 Euro | 57 | 21 | 24 | 16 | 24 | 17,5 |

GTX1080Ti (RAM+500MHz,Core + 100MHz) | 12 | 710 Euro | 64 | 21 | 24 | 12 | 24 | 18 |

DUAL Vega 56 BIOS V64 HBM 1050MHz | 2 x 10,5 | 800-1000 Euro | 72 | 24 | 24 | 24 | 24 | 18,5 |

Alle Benchmarks mit Version 14 von DaVinci Resolve Studio

Alle Werte stellen die Wiedergabe in fps dar,bis auf "Max Num Curved Nodes" (=Anzahl der maximalen Nodes bei ruckelfreier 24p-Wiedergabe).

Wie man gut sehen kann spielt die Vega 56, frisch aus der Packung genommen und unoptimiert (Stock) mindestens eine Liga unter einer unoptimierten Nvidia GTX 1080 Ti (Stock). Ohne das Vega 64 Bios lässt sich die Karte dabei auch kaum gewinnbringend tunen. Nach dem Aufspielen des Vega 64 Bios nähert sich die Karte jedoch schon deutlicher an die GTX 1080 Ti an. Mit den von uns betriebenen Optimierungen gelingt es der Vega 56 schließlich sogar, den bisherigen NVidia Spitzenreiter hinter sich zu lassen. Tuned man auch den Speicherzugriff der 1080Ti (+ 500 MHz) und gibt dem Nvidia Core auch nochmal 100 MHz mehr so liegen beide Karten wieder ungefähr gleichauf, wobei einmal die eine und einmal die andere einen Test für sich gewinnen kann. Der Stromverbrauch der beiden Karten ist in diesem Fall jedoch auch fast identisch (ca. 235W bei Spitzenlast). Unsere Gigabyte GTX 1080 Ti lärmt in diesem Fall jedoch ebenfalls auf einem gehörigen Geräuschlevel.